Bandwidth là số bit dữ liệu trong 1 giây có thể gửi trên đường truyền. Giá trị của bandwidth tùy thuộc vào tốc độ đường truyền vật lý (serial, fastEthernet…) hoặc tốc độ xung nhịp truyền dữ liệu (clock rate) của interface. Trong một số trường hợp thì tốc độ bandwidth bằng với tốc độ đường truyền vật lý hoặc bằng với tốc độ xung nhịp truyền dữ liệu. Ví dụ, mạng point-to-point.

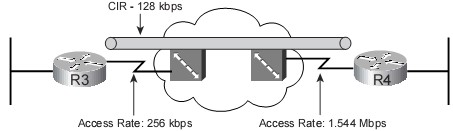

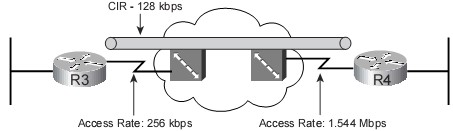

Theo hình 1, giả sử tốc độ bandwidth của đường truyền vật lý là 64Kbps thì R1 sẽ truyền dữ liệu cho R2 với bandwidth là 64Kbps và ngược lại. Trong một số trường hợp khác, tốc độ bandwidth thường nhỏ hơn tốc độ tốc độ đường truyền vật lý. Ví dụ, mạng Frame Relay thì tốc độ bandwidth là CIR (Commited Information Rate – tốc độ truyền dữ liệu được cam kết bởi nhà cung cấp dịch vụ).

Theo hình 2, R3 phải truyền với tốc độ bandwidth là 256Kbps và R4 là 1.544Mbps (T1), trong khi tốc độ CIR chỉ là 128Kbps. Tình huống đặt ra cho cả hai trường hợp (hình 1 và hình 2) là nếu lưu lượng mạng được truyền đi nhiều và với tốc độ lớn thì các hàng đợi sẽ đầy và có thể xảy ra nghẽn mạng. Lúc này, làm cho các ứng dụng bị chậm, các gói tin bị đánh rớt và sẽ vào trạng thái truyền lại (gói tin TCP – Transmission Control Protocol). Do đó, bandwidth là một nguyên nhân gây ảnh hưởng đến QoS.

Tăng bandwidth là công cụ có thể cải thiện vấn đề về bandwidth. Vài công cụ khác như: Nén, phân lượng bandwidth cần thiết cho các lưu lượng mạng ưu tiên hơn, hàng đợi.

- Nén: Nén cả IP header và dữ liệu tải, làm giảm số bits dữ liệu truyền.

- Phân lượng bandwidth cần thiết cho các lưu lượng mạng ưu tiên hơn: Ví dụ, hệ thống mạng có hai dịch vụ mạng là Voice và FTP. Lưu lượng Voice luôn được ưu tiên hơn nên sẽ được dành 75% bandwidth, 25% bandwidth còn lại là cho lưu lượng FTP.

- Hàng đợi: Tạo ra nhiều hàng đợi và sau đó lập Scheduling cho các gói tin trong từng hàng đợi tương ứng. Đồng thời bảo đảm lượng bandwidth tối thiểu cho một hàng đợi cụ thể.

Theo hình 3, R1 được cấu hình 2 hàng đợi (Queue 1 và Queue 2). Giả sử có 4 gói tin đến R1. Các gói 1, 2, 3 được phân loại vào class ít ưu tiên hơn nên được router đưa vào hàng đợi Queue 1 và chỉ được truyền với 25% bandwidth. Gói tin thứ 4 đến sau cùng nhưng được phân loại vào class có độ ưu tiên cao nên được router đưa vào hàng đợi Queue 2 và được truyền với 75% bandwidth. Gói tin thứ 4 đến sau nhưng vẫn được truyền đi trước.

Hình 1: Ví dụ tốc độ bandwidth trong mạng point-to-point

Theo hình 1, giả sử tốc độ bandwidth của đường truyền vật lý là 64Kbps thì R1 sẽ truyền dữ liệu cho R2 với bandwidth là 64Kbps và ngược lại. Trong một số trường hợp khác, tốc độ bandwidth thường nhỏ hơn tốc độ tốc độ đường truyền vật lý. Ví dụ, mạng Frame Relay thì tốc độ bandwidth là CIR (Commited Information Rate – tốc độ truyền dữ liệu được cam kết bởi nhà cung cấp dịch vụ).

Hình 2: Ví dụ tốc độ bandwidth trong mạng Frame Relay

Theo hình 2, R3 phải truyền với tốc độ bandwidth là 256Kbps và R4 là 1.544Mbps (T1), trong khi tốc độ CIR chỉ là 128Kbps. Tình huống đặt ra cho cả hai trường hợp (hình 1 và hình 2) là nếu lưu lượng mạng được truyền đi nhiều và với tốc độ lớn thì các hàng đợi sẽ đầy và có thể xảy ra nghẽn mạng. Lúc này, làm cho các ứng dụng bị chậm, các gói tin bị đánh rớt và sẽ vào trạng thái truyền lại (gói tin TCP – Transmission Control Protocol). Do đó, bandwidth là một nguyên nhân gây ảnh hưởng đến QoS.

Tăng bandwidth là công cụ có thể cải thiện vấn đề về bandwidth. Vài công cụ khác như: Nén, phân lượng bandwidth cần thiết cho các lưu lượng mạng ưu tiên hơn, hàng đợi.

- Nén: Nén cả IP header và dữ liệu tải, làm giảm số bits dữ liệu truyền.

- Phân lượng bandwidth cần thiết cho các lưu lượng mạng ưu tiên hơn: Ví dụ, hệ thống mạng có hai dịch vụ mạng là Voice và FTP. Lưu lượng Voice luôn được ưu tiên hơn nên sẽ được dành 75% bandwidth, 25% bandwidth còn lại là cho lưu lượng FTP.

- Hàng đợi: Tạo ra nhiều hàng đợi và sau đó lập Scheduling cho các gói tin trong từng hàng đợi tương ứng. Đồng thời bảo đảm lượng bandwidth tối thiểu cho một hàng đợi cụ thể.

Hình 3: Phân lượng bandwidth với việc sử dụng hàng đợi

Theo hình 3, R1 được cấu hình 2 hàng đợi (Queue 1 và Queue 2). Giả sử có 4 gói tin đến R1. Các gói 1, 2, 3 được phân loại vào class ít ưu tiên hơn nên được router đưa vào hàng đợi Queue 1 và chỉ được truyền với 25% bandwidth. Gói tin thứ 4 đến sau cùng nhưng được phân loại vào class có độ ưu tiên cao nên được router đưa vào hàng đợi Queue 2 và được truyền với 75% bandwidth. Gói tin thứ 4 đến sau nhưng vẫn được truyền đi trước.

Nguyễn Ngọc Đại – VnPro